果然,能打败昨天的OpenAI的,只有今天的OpenAI。

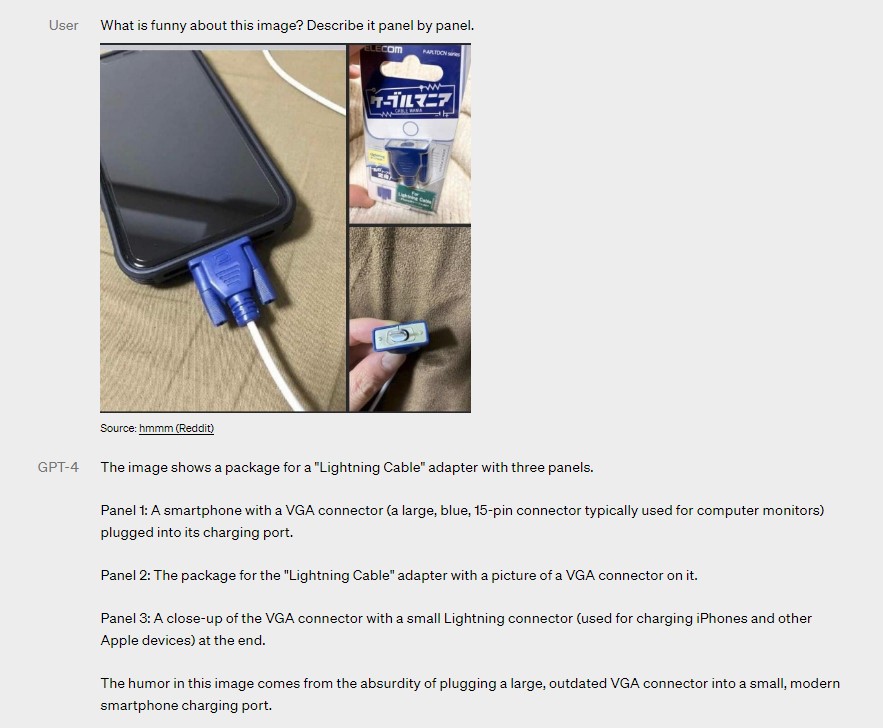

刚刚,OpenAI震撼发布了大型多模态模型GPT-4,支持图像和文本的输入,并生成文本结果。

GPT-4 实现了以下几个方面的飞跃式提升:强大的识图能力;文字输入限制提升至 2.5 万字;回答准确性显著提高;能够生成歌词、创意文本,实现风格变化。“GPT-4 是世界第一款高体验,强能力的先进AI系统,我们希望很快把它推向所有人”,OpenAI 工程师在介绍视频里说道。

似乎是想一口气终结这场游戏,OpenAI 既发布了论文(更像是技术报告)、 System Card,把 ChatGPT 直接升级成了 GPT-4 版的,也开放了 GPT-4 的 API。

另外,微软营销主管在 GPT-4 发布后第一时间表示:“如果你在过去六周内的任何时候使用过新的 Bing 预览版,你就已经提前了解了 OpenAI 最新模型的强大功能。”是的,微软的新必应早就已经用上了GPT-4。

第四代模型 GPT-4,重点强化了创作能力,如作曲,写小说等;增加了对于长文本的处理能力。最重要的,还是多了一种新的交互方式,就是对于图片的理解。也就是本次新论文的标题“多模模型” Large Multimodal Model。

在之前 ChatGPT 的使用中,因为没法插入图片,所以有些需要表述的内容,需要靠文字描述给它。现在不需要了,直接一丢就行,让它自己理解去。GPT-4 除本身带了对于图片 OCR 外,还有对位置和细节的理解能力。

从目前体验来看,GPT-4 的答复效果和 ChatGPT-3.5 Turbo 相比稍微提升,对于语义逻辑性的把握比老版本显著较好。但有个很大的问题,就是新模型的答复非常慢。本站个人猜测有两个可能:

- GPT-4 类似于 1750 亿参数的 GPT-3,目前是个未经充分优化的版本,而不是百亿参数级别的 ChatGPT 3.5 Turbo。这个模型从 OpenAI 限制访问次数也可以看出,实际上做答复也非常消耗 OpenAI 那边跑模型的算力。

- GPT-4 因为是个多模模型,所以流程要比纯文本的 ChatGPT-3.5 Turbo 显著复杂。大概率包含了图片向量理解的类似 CLIP 文本和图片向量对齐的中间模型等操作,整体运作也更为复杂。

OpenAI 花了 6 个月的时间使用对抗性测试程序和 ChatGPT 的经验教训对 GPT-4 进行迭代调整 ,从而在真实性、可控性等方面取得了有史以来最好的结果。

在过去的两年里,OpenAI 重建了整个深度学习堆栈,并与 Azure 一起为其工作负载从头开始设计了一台超级计算机。

一年前,OpenAI 在训练 GPT-3.5 时第一次尝试运行了该超算系统,之后他们又陆续发现并修复了一些错误,改进了其理论基础。

这些改进的结果是 GPT-4 的训练运行获得了前所未有的稳定,以至于 OpenAI 能够提前准确预测 GPT-4 的训练性能,它也是第一个实现这一点的大模型。

OpenAI 表示他们将继续专注于可靠的扩展,进一步完善方法,以帮助其实现更强大的提前预测性能和规划未来的能力,这对安全至关重要。

OpenAI 正在通过 ChatGPT 和 API(有候补名单)发布 GPT-4 的文本输入功能。图像输入功能方面,为了获得更广泛的可用性,OpenAI 正在与其他公司展开合作。

OpenAI 今天还开源了 OpenAI Evals,这是其用于自动评估 AI 模型性能的框架。OpenAI 表示此举是为了让所有人都可以指出其模型中的缺点,以帮助 OpenAI 进一步改进模型。

GPT-4 可以接受文本和图像形式的 prompt,新能力与纯文本设置并行,允许用户指定任何视觉或语言任务。

具体来说,它在人类给定由散布的文本和图像组成的输入的情况下生成相应的文本输出(自然语言、代码等)。在一系列领域 —— 包括带有文本和照片的文档、图表或屏幕截图上,GPT-4 展示了与纯文本输入类似的功能。

此外,它还可以通过为纯文本语言模型开发的测试时间技术得到增强,包括少样本和思维链 prompt。

尽管功能已经非常强大,但 GPT-4 仍与早期的 GPT 模型具有相似的局限性,其中最重要的一点是它仍然不完全可靠。OpenAI 表示,GPT-4 仍然会产生幻觉、生成错误答案,并出现推理错误。

目前,使用语言模型应谨慎审查输出内容,必要时使用与特定用例的需求相匹配的确切协议(例如人工审查、附加上下文或完全避免使用) 。

GPT-3是text in, text out。GPT-4是text & image in, text out。

期待下一步如何突破 text & image in, text & image out。

点击收藏本站,随时了解时事热点、娱乐咨询、游戏攻略等更多精彩文章。